生成AIの活用が進む一方で、「情報漏洩や著作権問題が心配」「どこまで安全に使えるのかわからない」と不安を感じている方も多いのではないでしょうか。実際、生成AIには法的・技術的なリスクが存在し、対策を怠ると重大なトラブルにつながる恐れがあります。

そこで本記事では、生成AIを安全かつ効果的に活用するためのリスク対策を網羅的に解説します。ガイドラインの整備やツール選定、セキュリティチェックまで具体的に解説しているので、安心して生成AIを使いたい方はぜひ参考にしてください。

生成AIとは

生成AIとは、学習したデータをもとに新しいコンテンツを作り出す技術を指します。例えば、文章・画像・音楽・動画など、多くの形式のコンテンツが対象です。

専門知識がなくても短時間で文章や画像が作成できるため、業務の効率化に役立ちます。また、新しいアイデアを生む手段としても注目されており、ビジネスや教育現場など幅広い分野で活用が進んでいます。

関連記事:生成AIにできること・できないことを徹底解説|今すぐ使える活用例も紹介

生成AIを利用する際のリスク

生成AIを利用する際は、以下の5つのリスクがあることを確認しておきましょう。

- 著作権侵害

- 差別的な表現やヘイトスピーチの生成

- 創造性の低下

- 誤情報の拡散

- セキュリティのリスク

それぞれ解説します。

関連記事:生成AI導入・活用時の課題と解決策|注意点と今後の展望を予想

著作権侵害

生成AIでよく問題になるのが著作権です。AIが作るコンテンツは、学習データに似た要素を含むことがあります。そのため、作品の一部が誰かの著作物と似ていると、著作権を侵害していると見なされる場合があります。特に商用利用する際は注意が必要です。

AIは過去の情報をもとに出力するため、著作権の問題からは逃れられないと言えるでしょう。適切な知識を持ち、利用方法を見直すことが大切です。

出展:文化庁|AIと著作権

差別的な表現やヘイトスピーチの生成

生成AIは、倫理的な配慮が必要なツールです。出力された内容が意図せず差別的な表現やヘイトスピーチを含むことがあります。

AIは学習元のデータに影響を受けるため、偏った情報をもとに不適切な内容を生成するリスクがあります。また、フェイクニュースの一部として悪用されることも考えられるでしょう。こうした問題を防ぐには、ガイドラインを整えた上で運用し、内容を人が確認する体制が欠かせません。

創造性の低下

生成AIの登場により、人間の創造力が失われるのではないかと心配する声もあります。たしかにAIは、短時間で高品質なコンテンツを作ることができるため、単純な作業はAIの方が得意だと言えるでしょう。

しかし、AIはツールにすぎず、人の想像力や工夫を完全に代替するものではありません。生成AIと人間が協力することで、より優れたアイデアが生まれる可能性があります。使い方次第で創造性を高めることも可能です。

誤情報の拡散

生成AIは、人が作ったように見える自然な文章を生成できます。その一方で、間違った情報をもっともらしく書いてしまうこともあります。これを「ハルシネーション」と呼びます。

情報が本当かどうか見分けるのが難しいため、誤った内容が広まりやすい点が問題です。誤情報を防ぐには、出典を確認したり複数の情報と照らし合わせたりする習慣が必要です。AIの出力結果をすべて信じるのではなく、人の目でチェックすることが重要です。

セキュリティのリスク

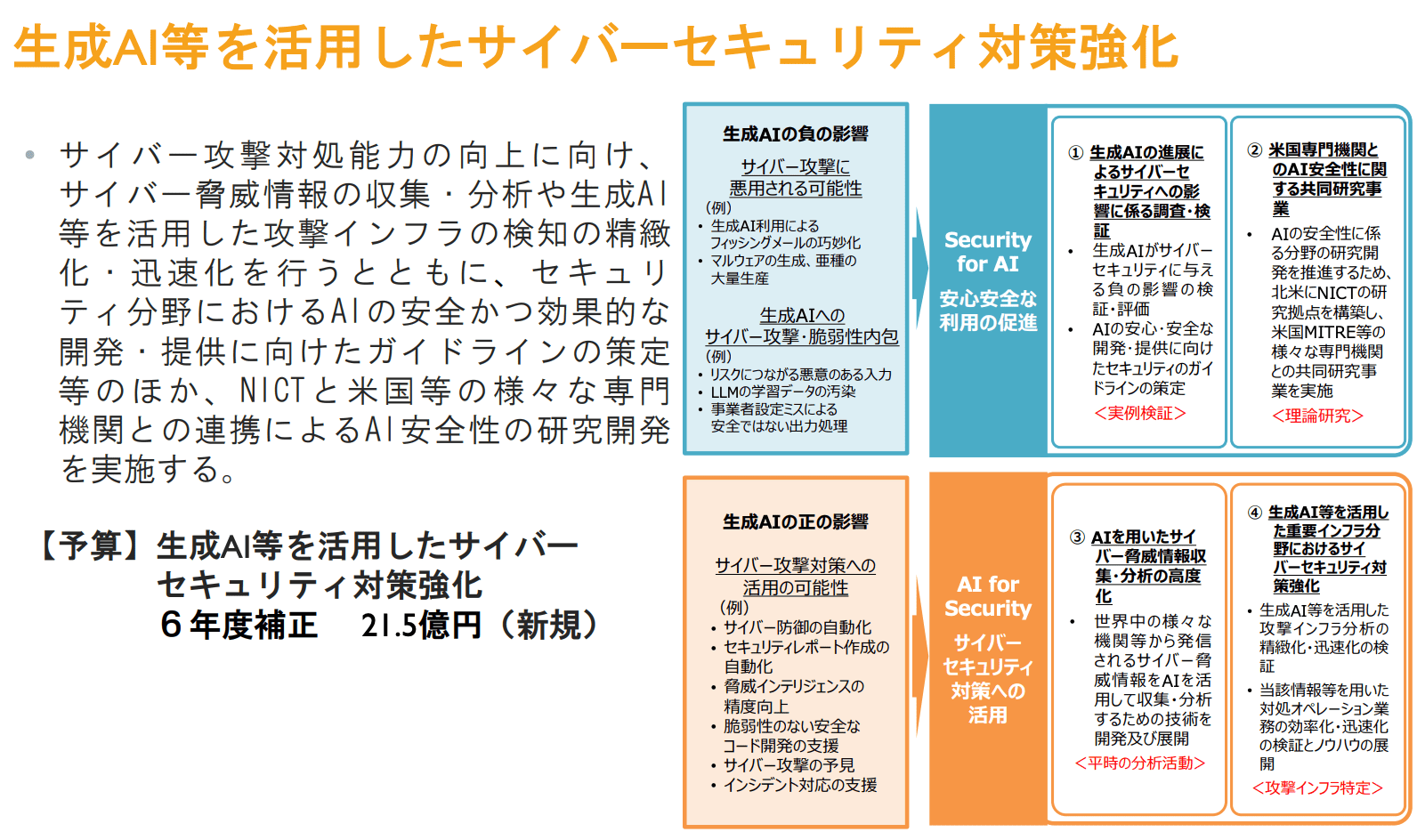

生成AIを使う上での技術的なリスクとして、情報漏洩や不正利用が挙げられます。AIに入力した内容が、第三者に悪用される可能性もあります。とくに個人情報や機密データを扱う場合、セキュリティ対策を怠ると大きな問題につながります。

また、不正なAIツールを利用することで、システムにウイルスが侵入する恐れもあるでしょう。こうしたリスクに備えるためにも、信頼性のあるAIツールを選び、アクセス制限や認証を導入することが求められます。

出典:総務省|生成AI等を活用したサーバーセキュリティ対策強化

生成AIの利用時の技術的なリスク対策4選

生成AIを活用する際には、技術的な観点からもリスク管理が重要です。情報漏洩や誤使用を防ぐためには、ツールの選び方や設定方法に注意を払う必要があります。以下では、具体的な技術的対策を4つ紹介します。

生成AIにアクセス制限・認証を設ける

生成AIを安全に利用するためには、アクセスできる人を限定することが基本です。誰でも自由に使える状態では、機密情報の漏洩や悪意ある利用につながる恐れがあります。

対策としては、ユーザーごとにIDとパスワードを設定したり、社内ネットワーク内のみ利用できるよう制限をかける方法があります。必要最低限の人だけが利用できる環境を整えることで、不正アクセスのリスクを抑えられるでしょう。

セキュリティ診断済みのAIツールを利用する

生成AIツールの中には、安全性の確認が不十分なものも存在します。信頼できるAIツールを選ぶためには、第三者機関によるセキュリティ診断を受けているか確認することが大切です。

セキュリティ診断済みのツールであれば、情報漏洩やウイルス感染などのリスクが低いと言えます。また、企業が提供する公式ツールを利用することで、サポート体制も整っており安心感が得られるでしょう。ツール選定の段階から安全性を意識することが重要です。

ログ管理機能を活用して利用履歴を記録する

生成AIの使用履歴を記録しておくことで、不正な利用があった際にすぐに確認できます。ログ管理機能を活用すれば、誰がいつどのようにAIを使ったのかを後から把握できるため、トラブルの早期発見につながるでしょう。

とくにチームなど複数人でAIを共有している場合は、履歴の確認が重要です。履歴が残る環境で利用することで、使う人の意識も高まり、より安全な運用ができるようになるでしょう。

生成AIの出力結果にフィルタリング処理を加える

生成AIが出力した情報には、不適切な内容が含まれる可能性があります。差別的な言葉や誤情報がそのまま表示されてしまうと、トラブルの原因となるでしょう。そこで必要なのが、出力結果に対してフィルタリングを行う仕組みです。フィルタリングとは、不適切な情報や不要なデータを自動的に取り除く仕組みのことを指します。

不適切な単語を自動的に検出・削除するフィルターを設定することで、リスクを減らせます。安心して使える環境をつくるためにも、AIの出力内容をそのまま信用せず、適切な確認処理を取り入れることが大切です。

生成AIの利用時の法的なリスク対策4選

生成AIの活用には法的な責任も伴います。ここでは、生成AIを安心して利用するために取り入れるべき法的対策を4つ紹介します。

著作権・商標権のある情報を入力・出力に使わない

生成AIに著作権や商標権のあるデータを入力すると、出力された結果が権利侵害になるおそれがあります。とくに画像や文章などは、学習元に似た表現を含むことがあり注意が必要です。

出力結果をそのまま商用利用すれば、著作権者からの指摘や法的トラブルに発展する可能性もあるでしょう。リスクを避けるには、著作権・商標権のある情報を使用しないルールを明確にし、チェック体制を整えることが大切です。

生成AIの利用に関する社内ルール・契約を整備する

生成AIを導入する際は、企業としての利用ルールや契約条件を定めておくことが不可欠です。使用目的や対象業務を明文化し、誤用やトラブルを防ぐ仕組みを作りましょう。

また、外部の生成AIツールを利用する場合は、利用規約を確認し、違反にならないよう注意が必要です。これらのルールが整っていれば、従業員も安心してAIを使える環境が整うでしょう。

出力内容の人間のチェックを義務づける体制を作る

生成AIは便利な反面、誤情報や不適切な表現を出すこともあります。そのまま公開や利用を行えば、意図しない問題が起こるかもしれません。

こうしたリスクを防ぐには、AIが出力した情報を人の目で必ず確認する体制を整える必要があります。しかしながら、上図のように総務省の各国のファクトチェックの認知度では、日本は知らないと回答した人が半数以上となっており、社内での教育が不可欠な状態です。

そのため、レビュー担当者を決め、チェックの手順を標準化することで、トラブルの回避と品質の安定化を実施する体制を整えることから始めましょう。

出典:令和5年版 情報通信白書|ファクトチェックの推進|総務省

学習データの出所(商用不可・改変不可など)の記録を残す

生成AIが学習したデータの出所を把握していないと、知らずに権利を侵害する可能性があります。とくに商用利用が禁止されていたり、改変が許可されていないデータを使っていた場合、後から問題になる恐れがあるでしょう。

そのため、学習データの使用条件や出所を記録として残しておくことが重要です。データ管理を徹底することで、法的リスクの抑制につながります。

生成AIを適切に利用するためのポイント

生成AIは便利な一方で、運用方法を誤るとトラブルに発展するリスクもあります。安全かつ効果的に活用するには、組織としての体制づくりや知識の共有が不可欠です。ここでは、生成AIを正しく使うためのポイント・取り組みを4つ紹介します。

会社・個人で利用する際はガイドライン(ルール)を作成する

生成AIを使う上で、ガイドライン(ルール)の作成は最初に行うべき対策です。明確なルールがなければ、使い方に個人差が出てしまい、情報漏洩や誤用につながるおそれがあります。

社内ルールでは「入力してよい情報」「出力結果の扱い方」「利用可能なツール」などを具体的に記載しましょう。個人での利用時も、利用目的を定めておくと安心です。

生成AIのリスクに対する研修を行う

社員や関係者に対して、生成AIのリスクを理解してもらうための研修は重要です。AIは便利な反面、誤情報や差別的な内容を出力する場合があるため、注意点を知っておく必要があります。

研修では、具体的なトラブル事例や安全な使い方を共有すると理解が深まるでしょう。また、定期的に研修を実施することで、リスクに対する意識を継続的に高められます。

セキュリティ対策のアップデートを実施する

生成AIの技術は日々進化しており、それに合わせてセキュリティ対策も見直す必要があります。過去の対策が最新のリスクに対応できない場合、情報漏洩やシステム侵害の危険が高まるでしょう。

対策の見直しでは、使用ツールの更新やアクセス権限の再設定などが含まれます。社内システムとの連携も確認し、問題点があればすぐに改善することが求められます。定期的なアップデートで安全性を維持しましょう。

関連記事:生成AIによるセキュリティリスクとは?対策や活用する際の注意点を解説

情報の最終チェックは必ず人が行う

生成AIが出力した情報は一見正確に見えても、内容に誤りや偏りが含まれる場合があります。そのため、最終的な判断は必ず人間が行いましょう。内容の妥当性や文脈の適切さを人が確認することで、リスクを大幅に減らせるでしょう。

まとめ

生成AIは業務効率を高める有用なツールですが、正しく使わなければ法的・技術的なリスクを引き起こす恐れがあります。著作権やセキュリティの問題を防ぐためには、適切なガイドラインの整備や人によるチェック体制が不可欠です。リスクを正しく理解し、具体的な対策を講じることで、安全かつ効果的に生成AIを活用できます。

リスク対策と成果の両立を目指した生成AI活用のためには、セキュリティや著作権リスクに対応できる専門人材の確保が重要です。Peaceful Morningでは、生成AIやDX領域に精通したプロ人材をご紹介するサービス「DX Boost」を提供しています。

グループ600万名を超える人材データベースから、リスク対策や運用ルール整備に強い人材を即日ご提案可能なため、スピード感を持って安全な生成AI活用が実現できます。生成AIの導入・運用に不安がある企業のご担当者様は、ぜひお気軽にご相談ください。

コメントを残す